Teams in der Systemadministration und Entwicklung von Red Hat Enterprise Linux (RHEL) verlassen sich seit langem auf bestimmte Tools, um Probleme zu diagnostizieren, kombiniert mit jahrelanger Intuition und Erfahrung. Mit zunehmender Komplexität der Umgebungen steigt jedoch auch die kognitive Belastung, die erforderlich ist, um Protokolle effektiv zu entschlüsseln und Probleme zu beheben.

Heute freuen wir uns, die Entwicklungsvorschau eines neuen MCP-Servers (Model Context Protocol) für RHEL anzukündigen. Dieser neue MCP-Server soll die Lücke zwischen RHEL und Large Language Models (LLMs) schließen und eine neue Ära der intelligenteren Fehlerbehebung einleiten.

Was ist der MCP-Server für RHEL?

MCP ist ein offener Standard, der es KI-Modellen ermöglicht, mit externen Daten und Systemen zu interagieren. Er wurde ursprünglich von Anthropic veröffentlicht und im Dezember 2025 an die Agentic AI Foundation der Linux Foundation gespendet. Der neue MCP-Server von RHEL befindet sich jetzt in der Enwicklungsvorschau und verwendet dieses Protokoll, um direkten, kontextbezogenen Zugriff auf RHEL von KI-Anwendungen zu ermöglichen, die das MCP-Protokoll unterstützen, wie Claude Desktop oder goose.

Wir haben bereits MCP-Server für Red Hat Lightspeed und Red Hat Satellite veröffentlicht, die eine Reihe interessanter Use Cases ermöglichen. Dieser neue MCP-Server erweitert diese Use Cases und wurde speziell für die detaillierte Fehlerbehebung auf RHEL-Systemen entwickelt.

Intelligentere Fehlerbehebung

Wenn Sie Ihr LLM über den neuen MCP-Server mit RHEL verbinden, sind beispielsweise folgende Use Cases möglich:

- Intelligente Protokollanalyse: Das Durchsuchen von Protokolldaten ist mühsam. Der MCP-Server ermöglicht LLMs die Aufnahme und Analyse von RHEL-Systemprotokollen. Diese Funktion ermöglicht eine KI-gestützte Ursachenanalyse und Anomalieerkennung, sodass Sie Rohprotokolldaten in verwertbare Informationen umwandeln können.

- Performance-Analyse: Der MCP-Server kann auf Informationen zur Anzahl der CPUs, zur durchschnittlichen Auslastung, zum Arbeitsspeicher und zur CPU- und Arbeitsspeicherauslastung laufender Prozesse zugreifen. So kann ein LLM-System den aktuellen Zustand des Systems analysieren, potenzielle Performance-Engpässe identifizieren und weitere leistungsbezogene Empfehlungen geben.

Damit Sie diese neuen Funktionen sicherer erkunden können, konzentriert sich diese Entwicklungsvorschau auf die schreibgeschützte MCP-Aktivierung. Der MCP-Server ermöglicht die Überprüfung und Empfehlung durch ein LLM und verwendet zur Authentifizierung Standard-SSH-Schlüssel. Er kann auch mit einer Positivliste für den Zugriff auf Protokolldateien und den Zugriff auf Protokollebene konfiguriert werden. Der MCP-Server lässt keinen Open Shell-Zugriff auf Ihr RHEL-System zu, da die vom MCP-Server ausgeführten Befehle vorab geprüft sind.

Anwendungsbeispiele

In diesen Beispielen verwende ich den KI-Agenten goose zusammen mit dem MCP-Server, um mit einem meiner RHEL 10-Systeme namens rhel10.example.com zu arbeiten. Goose unterstützt eine Reihe von LLM-Anbietern, darunter gehostete Online-Anbieter sowie lokal gehostete Anbieter. Ich verwende ein lokal gehostetes Modell.

Ich habe goose und den MCP-Server auf meiner Fedora-Workstation mit der SSH-Schlüsselauthentifizierung installiert, die mit rhel10.example.com eingerichtet ist.

Ich beginne mit einem Prompt, in dem ich das LLM bitte, mir bei der Überprüfung des Systemzustands von rhel10.example.com zu helfen:

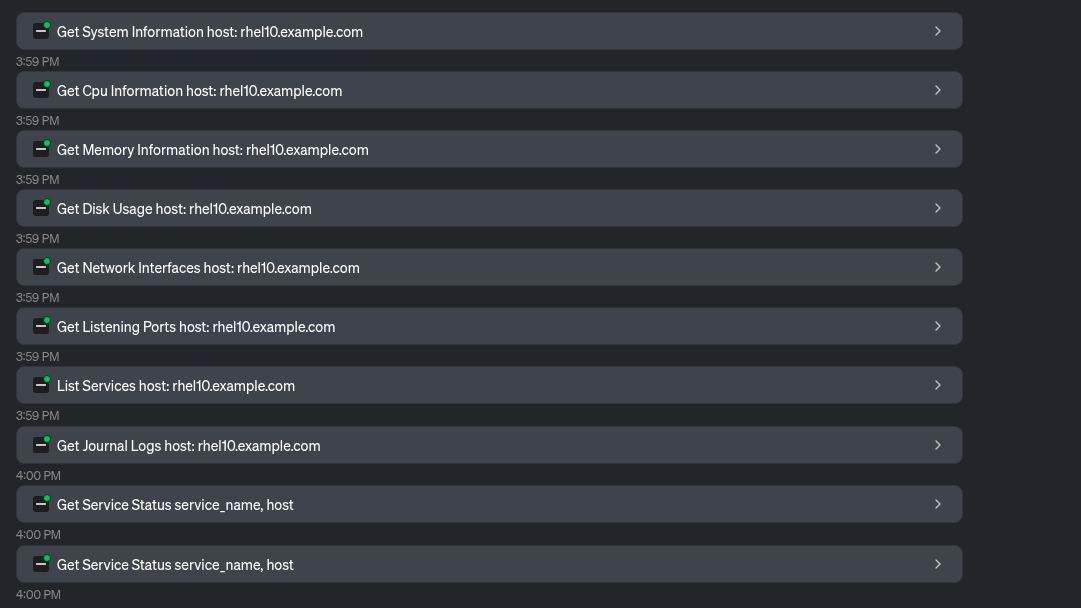

Das LLM verwendet eine Reihe von Tools, die vom MCP-Server zur Erfassung von Systeminformationen bereitgestellt werden:

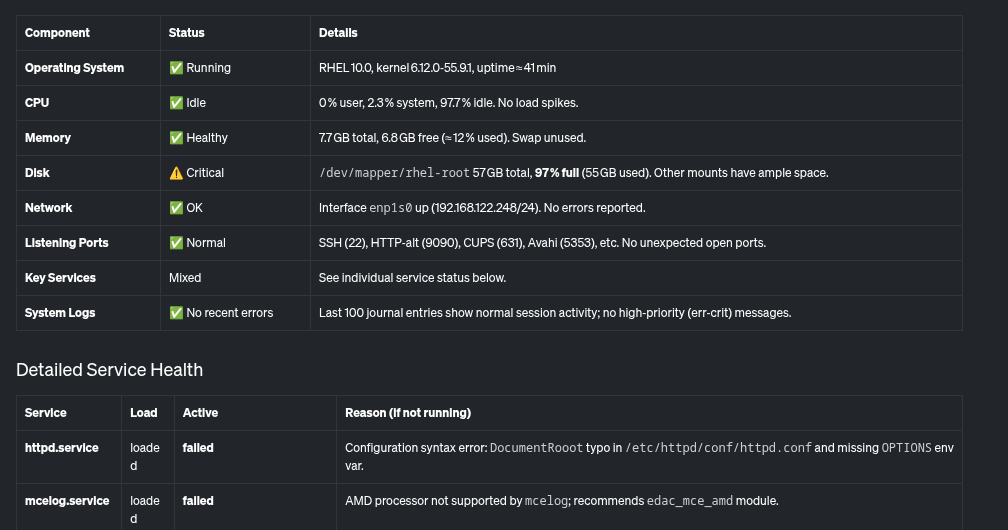

Auf Grundlage dieser Informationen bietet das LLM einen Überblick über das System und seinen Zustand, einschließlich folgender Tabelle:

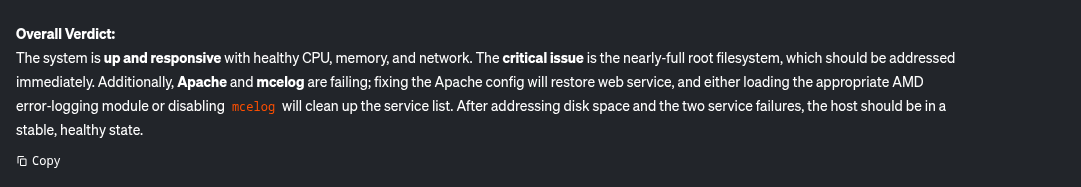

Zusätzlich erhalten Sie diese Zusammenfassung, in der kritische Probleme aufgeführt werden, die behoben werden müssen, z. B. das fast volle Root-Dateisystem und einige Services, die auf dem System ausfallen.

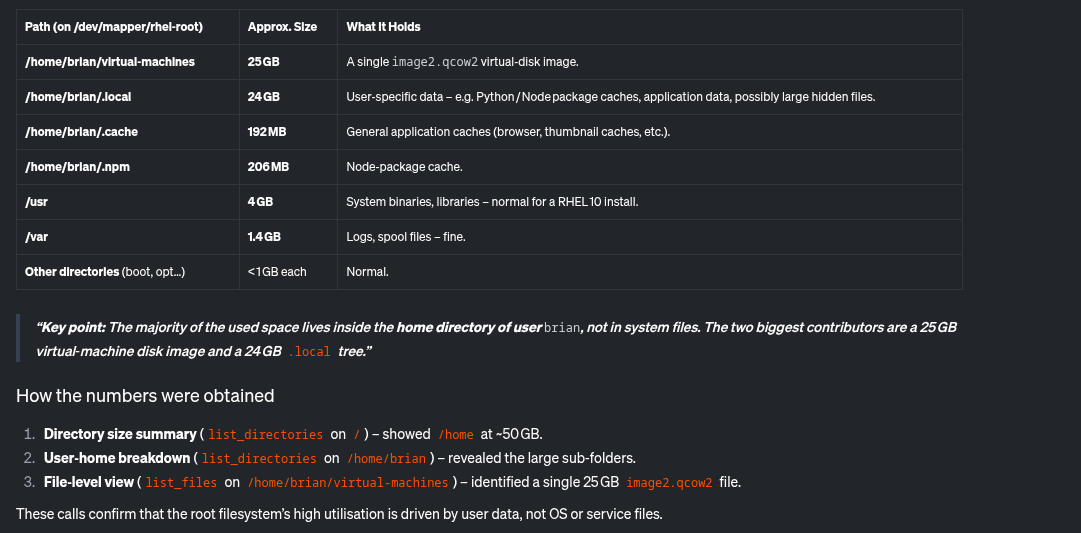

Sehen wir uns die identifizierten Probleme an. Ich bitte das LLM, herauszufinden, warum die Disk-Auslastung so hoch ist:

Das LLM verwendet vom MCP-Server bereitgestellte Tools, um zu ermitteln, was den meisten Speicherplatz beansprucht:

Auf dieser Grundlage ermittelt das LLM, dass das Verzeichnis /home/brian/virtual-machines eine 25 GB große Datei enthält und dass das Verzeichnis /home/brian/.local 24 GB Speicherplatz benötigt:

Abschließend werde ich das LLM auch noch um Hilfe bei httpd.service bitten, der zuvor als fehlgeschlagen gemeldet wurde.

Das LLM verwendet das vom MCP-Server bereitgestellte Read File Tool:

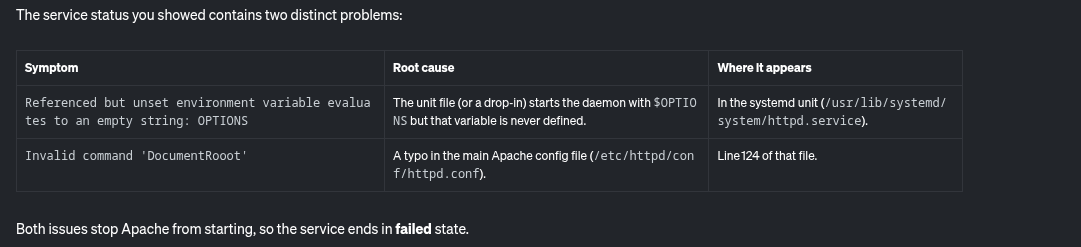

Auf dieser Grundlage meldet das LLM die möglichen Ursachen für ein Fehlschlagen von httpd.service:

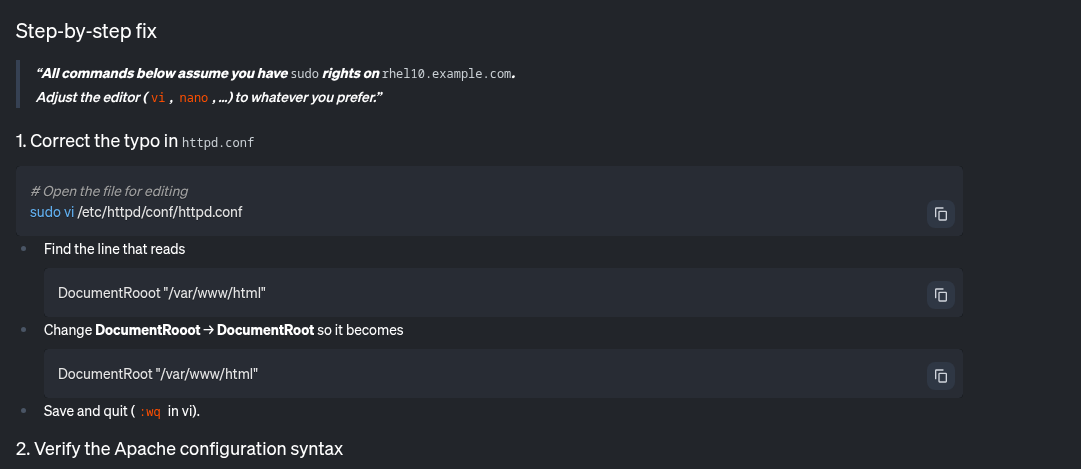

Darüber hinaus enthält es einige Schritt-für-Schritt-Anleitungen zur Behebung dieses Problems:

Mit dem MCP-Server für RHEL konnte ich potenzielle Probleme auf diesem System im Zusammenhang mit einem fast vollen Dateisystem und einem fehlgeschlagenen httpd-service leicht erkennen und beheben.

Nächste Schritte

Während wir mit einer schreibgeschützten Analyse beginnen, sieht unsere Roadmap die Ausweitung auf zusätzliche Use Cases vor. Wenn Sie den Entwicklungsprozess verfolgen möchten, sollten Sie unser Upstream-GitHub repository im Auge behalten. Wir freuen uns über Upstream-Beiträge! Wir sind sehr an Ihrem Feedback interessiert, etwa Verbesserungsanfragen, Fehlerberichte usw. Sie können das Team auf GitHub oder über die Fedora AI/ML Special Interest Group (SIG) erreichen.

Sind Sie bereit für intelligentere Fehlerbehebung?

Der MCP-Server für RHEL ist jetzt als Entwicklungsvorschau verfügbar. Verbinden Sie Ihre LLM-Client-Anwendung und sehen Sie, wie kontextbezogene KI die Verwaltung von RHEL verändern kann. Informationen zum Einstieg finden Sie in der Dokumentation von Red Hat und in der Upstream-Dokumentation.

Produkttest

Red Hat Enterprise Linux | Testversion

Über die Autoren

Brian Smith is a product manager at Red Hat focused on RHEL automation and management. He has been at Red Hat since 2018, previously working with public sector customers as a technical account manager (TAM).

Máirín Duffy is a Red Hat Distinguished Engineer and leads the Red Hat Enterprise Linux Lightspeed Incubation team at Red Hat as a passionate advocate for human-centered AI and open source. A recipient of the O’Reilly Open Source Award, Máirín first joined Red Hat as an intern in 2004 and has spent two decades in open source communities focusing on user experience in order to expand the reach of open source. A sought-after speaker and author, Mo holds 19 patents and authored 6 open source coloring books, including The SELinux Coloring Book.

Ähnliche Einträge

KI im Jahr 2026: Zwischen Hype, Verantwortung und echter Wertschöpfung

AI insights with actionable automation accelerate the journey to autonomous networks

Technically Speaking | Build a production-ready AI toolbox

Technically Speaking | Platform engineering for AI agents

Nach Thema durchsuchen

Automatisierung

Das Neueste zum Thema IT-Automatisierung für Technologien, Teams und Umgebungen

Künstliche Intelligenz

Erfahren Sie das Neueste von den Plattformen, die es Kunden ermöglichen, KI-Workloads beliebig auszuführen

Open Hybrid Cloud

Erfahren Sie, wie wir eine flexiblere Zukunft mit Hybrid Clouds schaffen.

Sicherheit

Erfahren Sie, wie wir Risiken in verschiedenen Umgebungen und Technologien reduzieren

Edge Computing

Erfahren Sie das Neueste von den Plattformen, die die Operations am Edge vereinfachen

Infrastruktur

Erfahren Sie das Neueste von der weltweit führenden Linux-Plattform für Unternehmen

Anwendungen

Entdecken Sie unsere Lösungen für komplexe Herausforderungen bei Anwendungen

Virtualisierung

Erfahren Sie das Neueste über die Virtualisierung von Workloads in Cloud- oder On-Premise-Umgebungen