Sie haben die Aufgabe, KI in Ihr Unternehmen zu integrieren. Doch der Weg vom Proof of Concept zur produktionsfähigen Anwendung ist oft ein Labyrinth aus fragmentierten Tools und komplexen Integrationen, insbesondere bei Use Cases für agentische KI. Die eigentliche Herausforderung ist nicht nur die Technologie, sondern die Entwicklung einer KI-Strategie, die skalierbar, zuverlässig und kontrollierbar ist.

Die Standardisierung ist ein Hauptfaktor bei der Bewältigung dieser Herausforderung, vor allem durch die Reduzierung der Komplexität und die Steigerung der Effizienz. Durch die Kombination von Model Context Protocol (MCP) und Llama Stack auf einer Plattform wie Red Hat OpenShift AI können Sie eine einheitliche und portierbare Umgebung für Ihre KI-Anwendungen schaffen.

OpenShift AI kann auch die Integration anderer agentischer Frameworks und Komponenten unterstützen, darunter Tools wie LangChain, LangGraph und CrewAI. Mit dem Ansatz von Red Hat können Sie die Entwicklung vereinfachen, Abläufe optimieren und Ihrem Unternehmen die erforderlichen Tools zur Verfügung stellen, mit denen Ihre verschiedenen Teams, wie KI-Entwicklungs- und Data Science-Teams, Ihre KI-Vision in einer zuverlässigen und konsistenten Umgebung in die Realität umsetzen können.

Die Bausteine eines intelligenten Agenten verstehen

Um resiliente KI-gestützte Anwendungen zu entwickeln, benötigen Sie eine Basis, die es intelligenten Agenten ermöglicht, auf die spezifischen Tools und Daten Ihres Unternehmens zuzugreifen und diese zu nutzen. Dies erfordert 2 Schlüsselkomponenten: eine standardisierte Methode zur Bereitstellung Ihrer Services und ein einheitliches Framework für die Interaktion mit ihnen.

Dies ist das Kernstück der agentischen KI, bei der ein autonomes System die beste Vorgehensweise und die zum Erreichen eines Ziels erforderlichen Tools bestimmen kann. Die Kombination aus MCP und Llama Stack bietet das Framework, damit diese Agenten effektiv agieren können.

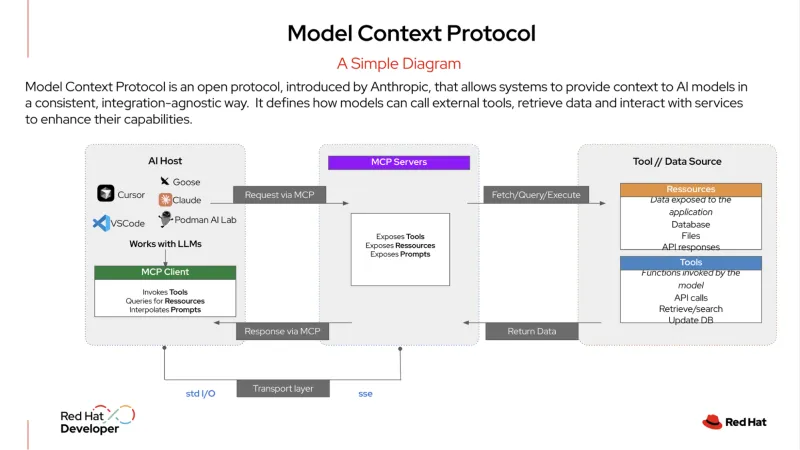

MCP ist ein offenes Protokoll, das die Integration Ihrer KI-Systeme mit externen Tools und Datenquellen standardisiert. Es wird als ein „USB-C-Port für KI-Anwendungen“ beschrieben. So wie Sie mit USB-C beliebige kompatible Geräte wie Monitore, Festplatten oder Tastaturen anschließen können, stellt ein MCP-Server die Services Ihrer Organisation in einem standardisierten Format bereit.

Ein KI-Agent kann sich dann mit diesem Server verbinden, um verfügbare Tools zu ermitteln und zu verwenden, sei es eine Datenbank, ein CRM-System (Customer Relationship Management) oder eine interne API. Dieses Protokoll bietet eine strukturierte Möglichkeit für KI-Agenten, sich mit Services zu verbinden, und erleichtert ihnen das Abrufen der Informationen, die sie zum Ausführen von Aufgaben benötigen.

Llama Stack ist ein Open Source-Framework, das einen einheitlichen, API-gesteuerten Ansatz für die Entwicklung und Bereitstellung generativer KI-Anwendungen (gen KI) bietet. Es bietet eine konsistente und portierbare Möglichkeit, die Komplexitäten der KI-Entwicklung und -Bereitstellung zu abstrahieren, und umfasst eine Suite von Unternehmenstools wie APIs für Inferenz, Retrieval-Augmented Generation (RAG) und KI-Agenten. Außerdem bietet es integrierte Komponenten für Sicherheit, Evaluierung und Beobachtbarkeit, mit denen Unternehmen produktionsbereite KI-Anwendungen erstellen können, die sowohl zuverlässig als auch skalierbar sind.

Ein Beispiel für agentische KI in Aktion

In der Unternehmens-IT kann agentenbasierte KI komplexe, mehrstufige Workflows handhaben, die eine dynamische Entscheidungsfindung erfordern. Beispielsweise kann ein hochentwickelter Agent anstelle einer einfachen Eins-zu-eins-Anfrage-und-Antwort als autonomer Service-Desk-Manager fungieren und Probleme mit minimalem menschlichen Eingriff beheben.

Hier ist ein Beispiel dafür, was dieser Agententyp tun könnte, wenn ein Nutzender ein Ticket für einen „Serviceausfall“ einreicht:

- Llama Stack erhält das erste Ticket. Das System empfängt die Meldung des Nutzenden zu einem Serviceausfall und kategorisiert diesen als Vorfall mit hoher Priorität.

- Der Agent verwendet MCP und formuliert einen Plan. Der Agent verwendet MCP, um die relevanten Tools zu identifizieren und zu ermitteln, auf die er Zugriff hat – etwa ein Überwachungsservice, ein Tool zur Protokollanalyse und ein Runbook-Automatisierungssystem. Mit diesem Kontext von MCP formuliert der Agent einen mehrstufigen Plan zur Untersuchung und Behebung des Problems.

- Der Agent führt den Plan mithilfe von MCP aus, um mit den ermittelten Tools zu kommunizieren.

- Zuerst verwendet der Agent ein Monitoring-Tool, um den Status der relevanten Services und Abhängigkeiten zu überprüfen.

- Anschließend ruft der Agent ein Protokollanalyse-Tool auf, um die aktuellen Protokolle für eine zugehörige Anwendung oder einen Red Hat OpenShift-Container zu überprüfen und nach Fehlern zu suchen.

- Sobald der Agent ein potenzielles Problem identifiziert hat (z. B. einen Pod-Absturz), verwendet er ein Diagnosetool, um das zugrunde liegende Problem zu ermitteln, etwa eine falsch konfigurierte Netzwerkrichtlinie oder eine volle Festplatte.

- Der Agent ergreift Korrekturmaßnahmen. Basierend auf der Diagnose verwendet der Agent MCP, um ein vorab genehmigtes Fehlerbehebungsskript aufzurufen, um den Pod neu zu starten und den Disk-Speicherplatz zu löschen. Anschließend überprüft der Agent den Servicestatus erneut, um zu bestätigen, dass das Problem behoben ist.

- Der Agent kommuniziert das Ergebnis. Der Agent verwendet ein internes Tool, um den Status des Tickets auf „gelöst“ zu aktualisieren, einschließlich einer Zusammenfassung der vorgenommenen Aktionen. Anschließend formuliert der Agent eine Nachricht an den Nutzenden, in der das Problem erklärt und bestätigt wird, dass der Service wieder online ist – und zwar ohne einen einzigen menschlichen Kontakt.

Durch die Verwendung von MCP zur Orchestrierung dieser Aktionen kann der Agent als autonomer und eigenständiger Service Desk arbeiten. Dadurch verringert sich die manuelle Belastung der IT-Teams, und sie haben mehr Zeit, sich auf strategischere Initiativen zu konzentrieren.

Ein optimierter Ansatz für Entwicklung und Produktion

Die Kombination aus Llama Stack und MCP verbessert das Entwicklererlebnis erheblich. Anstatt für einen spezifischen, monolithischen Stack zu entwickeln, können Ihre Entwicklungsteams eine standardisierte Abstraktionsebene über eine einzige API verwenden. Dies ermöglicht eine leistungsstarke Entwicklungsmethodologie „Inner Loop“, mit der sie ihre KI-Anwendungen auf einem lokalen Rechner unter Verwendung eines einzigen SDK entwickeln und testen können.

Da die APIs konsistent sind und die Services über ein standardisiertes Protokoll erkannt werden, können Ihre Entwicklungsteams darauf vertrauen, dass ihre Anwendung beim Deployment auf einer unternehmensgerechten Plattform genauso funktioniert.

Diese Portierbarkeit ist in der sich schnell verändernden KI-Umgebung unerlässlich. Entwicklungsteams können ihre Anwendung so erstellen, dass sie ein Modell verwendet. Wenn ein neues Modell aufkommt, das besser oder kostengünstiger ist, können sie zu diesem wechseln, ohne ihren Code neu schreiben zu müssen. Dies reduziert den Zeit- und Arbeitsaufwand für die Entwicklung, beschleunigt Innovation und sorgt für einen klaren Übergang von der Entwicklung zur Produktion.

Operative Konsistenz für KI-Workloads erreichen

Für Ihre Operations-Teams kann die Verwaltung einer Vielzahl von KI-Modellen und -Services eine erhebliche Komplexität darstellen. Wenn Sie jedoch einen standardisierten, auf Ihr Unternehmen zugeschnittenen KI-Stack auf einer Plattform wie OpenShift AI ausführen, erhalten Sie eine zentralisierte und konsistente Umgebung.

OpenShift AI bietet eine umfassende, bewährte Plattform für die Bereitstellung und den Betrieb von LLMs sowie die Ausführung der erforderlichen Datenbanken für RAG-Anwendungen. Außerdem können Ihre Teams vorhandene Microservice-Architekturen nutzen und sich reibungslos mit internen Systemen verbinden.

Ihre Operations-Teams können diese KI-Anwendungen auch mithilfe ihrer standardmäßigen GitOps-Prozesse bereitstellen und verwalten. Dadurch können dieselben Workflows wie für herkömmliche cloudnative Anwendungen auf KI-Workloads angewendet werden, was die Verwaltung und Wartung im großen Maßstab vereinfacht. Dies vereinfacht den Prozess von der Entwicklung bis zur Produktion und sorgt für operative Konsistenz in Ihren Hybrid Cloud-Umgebungen.

Durch die Kombination der Leistungsfähigkeit von Open Source-Technologien wie Llama Stack und MCP – und die Möglichkeit der Integration anderer Agenten-KI-Frameworks wie LangChain, Haystack, LlamaIndex und PydanticAI – bietet Red Hat AI eine zuverlässige Basis für die Entwicklung, Bereitstellung und Verwaltung von KI-Anwendungen in Ihrer gesamten Hybrid Cloud.

Mehr erfahren

Bereit für den Einstieg? Erfahren Sie mehr über Red Hat AI durch unsere Testversionen, Consulting Services, Trainings und Zertifizierungen und vieles mehr.

Ressource

Das adaptive Unternehmen: KI-Bereitschaft heißt Disruptionsbereitschaft

Über die Autoren

Younes Ben Brahim is a Principal Product Marketing Manager at Red Hat, focusing on the strategic positioning and market adoption of Red Hat's AI platform offerings. Younes has spent over 15 years in the IT industry leading product marketing initiatives, managing product lifecycles for HPC & AI, and delivering consulting services.

Prior to Red Hat, he has worked with companies like NetApp, Dimension Data, and Cisco Systems, providing technical solutions and product strategy for enterprise infrastructure and software projects.

Carlos Condado is a Senior Product Marketing Manager for Red Hat AI. He helps organizations navigate the path from AI experimentation to enterprise-scale deployment by guiding the adoption of MLOps practices and integration of AI models into existing hybrid cloud infrastructures. As part of the Red Hat AI team, he works across engineering, product, and go-to-market functions to help shape strategy, messaging, and customer enablement around Red Hat’s open, flexible, and consistent AI portfolio.

With a diverse background spanning data analytics, integration, cybersecurity, and AI, Carlos brings a cross-functional perspective to emerging technologies. He is passionate about technological innovations and helping enterprises unlock the value of their data and gain a competitive advantage through scalable, production-ready AI solutions.

Will McGrath is a Senior Principal Product Marketing Manager at Red Hat. He is responsible for marketing strategy, developing content, and driving marketing initiatives for Red Hat OpenShift AI. He has more than 30 years of experience in the IT industry. Before Red Hat, Will worked for 12 years as strategic alliances manager for media and entertainment technology partners.

Roberto is a Principal AI Architect working in the AI Business Unit specializing in Container Orchestration Platforms (OpenShift & Kubernetes), AI/ML, DevSecOps, and CI/CD. With over 10 years of experience in system administration, cloud infrastructure, and AI/ML, he holds two MSc degrees in Telco Engineering and AI/ML.

Cedric Clyburn (@cedricclyburn), Senior Developer Advocate at Red Hat, is an enthusiastic software technologist with a background in Kubernetes, DevOps, and container tools. He has experience speaking and organizing conferences including DevNexus, WeAreDevelopers, The Linux Foundation, KCD NYC, and more. Cedric loves all things open-source, and works to make developer's lives easier! Based out of New York.

Ähnliche Einträge

AI insights with actionable automation accelerate the journey to autonomous networks

Fast and simple AI deployment on Intel Xeon with Red Hat OpenShift

Technically Speaking | Build a production-ready AI toolbox

Technically Speaking | Platform engineering for AI agents

Nach Thema durchsuchen

Automatisierung

Das Neueste zum Thema IT-Automatisierung für Technologien, Teams und Umgebungen

Künstliche Intelligenz

Erfahren Sie das Neueste von den Plattformen, die es Kunden ermöglichen, KI-Workloads beliebig auszuführen

Open Hybrid Cloud

Erfahren Sie, wie wir eine flexiblere Zukunft mit Hybrid Clouds schaffen.

Sicherheit

Erfahren Sie, wie wir Risiken in verschiedenen Umgebungen und Technologien reduzieren

Edge Computing

Erfahren Sie das Neueste von den Plattformen, die die Operations am Edge vereinfachen

Infrastruktur

Erfahren Sie das Neueste von der weltweit führenden Linux-Plattform für Unternehmen

Anwendungen

Entdecken Sie unsere Lösungen für komplexe Herausforderungen bei Anwendungen

Virtualisierung

Erfahren Sie das Neueste über die Virtualisierung von Workloads in Cloud- oder On-Premise-Umgebungen