-

Produkte und Dokumentation Red Hat AI

Eine Plattform mit Produkten und Services für die Entwicklung und Bereitstellung von KI in der Hybrid Cloud.

Red Hat AI Enterprise

Erstellen, entwickeln und stellen Sie KI-gestützte Anwendungen in der Hybrid Cloud bereit.

Red Hat AI Inference Server

Optimieren Sie die Modell-Performance mit vLLM für schnelle und kosteneffiziente Inferenz in großem Umfang.

Red Hat Enterprise Linux AI

Entwickeln, testen und führen Sie Sie generative KI-Modelle mit optimierten Inferenzfunktionen aus.

Red Hat OpenShift AI

Entwickeln und implementieren Sie KI-gestützte Anwendungen und Modelle in großem Umfang in Hybrid-Umgebungen.

-

Lernen Grundlagen

-

KI-Partner

Red Hat AI

Nutzen Sie Ihre eigenen Ressourcen und Insights, um Mehrwert durch KI zu schaffen – mit der Freiheit, die Ihr Unternehmen braucht.

Red Hat® AI basiert auf Open Source-Technologie und unterstützt Sie beim Entwickeln und Ausführen zuverlässiger KI-Lösungen.

Zugang zu KI für Unternehmen dank Red Hat AI

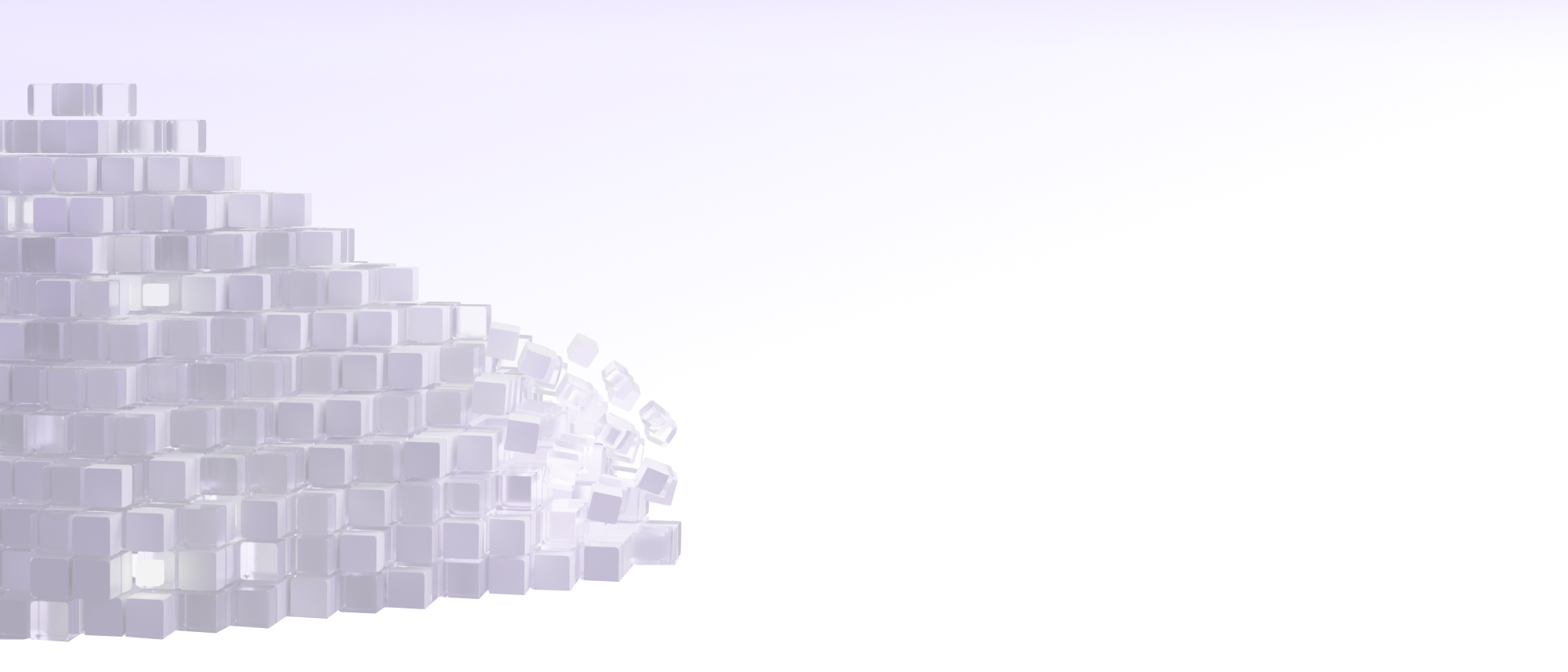

Einführung von Red Hat AI Enterprise: Eine Plattform, die die Lücke zwischen KI-Experimenten und globalem Umfang schließen soll. Die Lösung bietet Funktionen für Inferenz, Modellanpassung, Deployment sowie Management und unterstützt flexibel beliebige Modelle auf unterschiedlicher Hardware in verschiedenen Umgebungen.

Ihre Modelle. Ihre Daten. Ihre Entscheidung.

Die Voraussetzung dafür, dass KI-Anwendungen optimal arbeiten können, ist schnelle, kostengünstige Inferenz. Red Hat AI bietet dafür mit llm-d – einem Framework für verteilte Inferenz in großem Umfang – eine einheitliche und flexible Plattform.

Llm-d baut auf dem Erfolg von vLLM auf und profitiert von den bewährten Kubernetes-Vorteilen. So erfolgt eine konsistente und effiziente Verarbeitung mit planbarer Performance.

Wenn Unternehmen agentische KI (Agentic AI) nutzen, benötigen sie mehr als Effizienz. Sie benötigen ein auf Zusammenarbeit ausgerichtetes Framework, um Modelle, Daten und KI-Workflows in der Hybrid Cloud zu verbinden.

Die Einführung einer einheitlichen, auf Llama Stack basierenden API-Ebene eröffnet Möglichkeiten für eine Vielzahl von KI-Funktionen. Dazu zählt die Integration mit MCP (Model Context Protocol), die das Bereitstellen und Ausführen von agentischer KI (Agentic AI) in großem Umfang in Produktivumgebungen vereinfacht.

Dienstag, 17. Februar um 11:00 Uhr EST

Was ist neu und wie geht es weiter mit Red Hat AI?

Lassen Sie sich von Führungskräften von Red Hat AI über die aktuellen Fortschritte bei Red Hat AI berichten.

Portfolio von Red Hat AI

Red Hat AI Enterprise ist eine integrierte KI-Plattform für das Deployment und Management effizienter, kostengünstiger Modelle, Agenten und Anwendungen.

Die Lösung vereinheitlicht Modell- und Anwendungs-Lifecycles und bietet zentrale Funktionen wie Modell-Tuning, leistungsstarke Inferenz und Workflow-Management agentischer KI. Die Plattform ist auf Flexibilität ausgelegt und unterstützt beliebige Modelle und Hardwarekomponenten sowie standortunabhängige Deployments.

Red Hat AI Inference Server optimiert die Modellinferenz in der Hybrid Cloud für schnellere, kostengünstigere Modellbereitstellungen.

Auf der Basis von vLLM bietet er Zugang zu validierten und optimierten Modellen von Drittanbietern auf Hugging Face. Außerdem sind LLM Compressor-Tools enthalten.

Red Hat OpenShift® AI basiert auf den Funktionen von Red Hat OpenShift und bietet eine zuverlässige und skalierbare KI-Plattform für Training, Tuning, Bereitstellung und Überwachung von ML-Modellen.

Red Hat Enterprise Linux® AI ist eine sofort einsatzbereite Plattform für die konsistente Ausführung von Large Language Models (LLMs) in individuellen Serverumgebungen.

Die integrierten Inferenzfunktionen, die im Image-Modus ausgeführt werden, ermöglichen eine schnelle, kostengünstige Hybrid Cloud-Inferenz, die mit vLLM den Durchsatz maximiert und die Latenz minimiert.

Validierte Performance für reale Ergebnisse

Red Hat AI bietet Zugang zu einer Reihe betriebsbereiter, validierter Modelle von Drittanbietern, die effizient mit vLLM auf unserer Plattform ausgeführt werden.

Nutzen Sie validierte Drittanbietermodelle von Red Hat, um die Modell-Performance zu testen und die Inferenz zu optimieren. Außerdem erhalten Sie Anleitungen, um die Komplexität zu reduzieren und die Einführung von KI zu beschleunigen.

Individuelle KI-Lösungen für Ihre Anforderungen

Generative KI

Neue Inhalte wie Text und Softwarecode produzieren

Mit Red Hat AI können Sie die generativen KI-Modelle Ihrer Wahl schneller, mit weniger Ressourcen und geringeren Inferenzkosten ausführen.

Prädiktive KI

Muster erkennen und zukünftige Ergebnisse prognostizieren

Mit Red Hat AI können Unternehmen prädiktive Modelle entwickeln, trainieren, bereitstellen und überwachen und dabei die Konsistenz in der Hybrid Cloud wahren.

Operationalisierte KI

Systeme entwickeln, die die Wartung und Bereitstellung von KI in großem Umfang unterstützen

Mit Red Hat AI können Sie den Lifecycle von KI-fähigen Anwendungen managen und überwachen, gleichzeitig Ressourcen einsparen und die Compliance mit Datenschutzbestimmungen sicherstellen.

Agentische KI

Entwickeln Sie Workflows, die komplexe Aufgaben unter eingeschränkter Überwachung ausführen.

Red Hat AI bietet einen flexiblen Ansatz und eine stabile Basis für die Entwicklung, Verwaltung und Bereitstellung agentischer KI-Workflows in vorhandenen Anwendungen.

Mehr KI-Partner. Mehr Möglichkeiten für Fortschritt.

Fachleute und Technologien werden zusammengeführt, damit unsere Kunden mit KI mehr erreichen können. Viele verschiedene Technologiepartner arbeiten mit Red Hat zusammen, um ihre Kompatibilität mit unseren Lösungen zu zertifizieren.

Weitere KI Success Stories vom Red Hat Summit und AnsibleFest 2025

Turkish Airlines verdoppelte die Geschwindigkeit der Bereitstellung durch unternehmensweiten Zugang zu Daten.

JCCM konnte die Prozesse zur Umweltverträglichkeitsprüfung (UVP) in der Region mithilfe von KI verbessern.

Die Denizbank verkürzte die Markteinführungszeiten von Tagen auf wenige Minuten.

Hitachi hat KI in seinem gesamten Unternehmen mit Red Hat OpenShift AI operationalisiert.

KI-Schnellstarts

Eine Vielzahl praktischer Geschäftsbeispiele aus unserer Community, die aktuellen Kunden von Red Hat den Einstieg erleichtern.

Red Hat AI in der Praxis

Ortec Finance beschleunigt Wachstum und verkürzt Markteinführungszeiten

Ortec Finance, ein globaler Anbieter von Technologien und Lösungen für das Risiko- und Renditemanagement, stellt ML-Modelle auf Microsoft Azure Red Hat OpenShift bereit und führt Red Hat AI ein.

DenizBank unterstützt Data Scientists

DenizBank entwickelt KI-Modelle, um Kredite für Kunden und gleichzeitig möglichen Betrug zu identifizieren. Mit Red Hat AI erreichten die Data Scientists der Bank eine neue Stufe der Autonomie in Bezug auf die unternehmenseigenen Daten.

Entwicklung auf einer zuverlässigen Basis

Weltweit vertrauen Unternehmen auf unser umfassendes Portfolio an Lösungen für die Hybrid Cloud-Infrastruktur, Anwendungsservices, cloudnative Anwendungsentwicklung und Automatisierung für die schnelle und kosteneffiziente Bereitstellung von IT-Services auf verschiedenen Infrastrukturen.

Red Hat Enterprise Linux

Support für Anwendungsbereitstellungen – ob On-Premise, in der Cloud oder am Edge – in einer flexiblen Betriebsumgebung

Red Hat OpenShift

Schnelle Entwicklung und Bereitstellung von Anwendungen in großem Umfang und Modernisierung bereits vorhandener Anwendungen

Red Hat Ansible

Automation Platform

Automation Platform

Entwicklung, Verwaltung und dynamische Skalierung von Automatisierung in Ihrem gesamten Unternehmen

Red Hat AI

Tuning kleiner Modelle mit unternehmensrelevanten Daten sowie Entwicklung und Bereitstellung von KI-Lösungen in Hybrid Cloud-Umgebungen