Les équipes d’administration système et les développeurs Red Hat Enterprise Linux (RHEL) s'appuient depuis longtemps sur un ensemble d'outils spécifiques pour diagnostiquer les problèmes, ainsi que sur des années d'apprentissage et d'expérience. Toutefois, plus les environnements se complexifient, plus la charge cognitive nécessaire pour déchiffrer efficacement les journaux et résoudre les problèmes augmente.

Aujourd'hui, nous avons le plaisir d'annoncer la disponibilité d'une version préliminaire pour les développeurs d'un nouveau serveur MCP (Model Context Protocol) pour RHEL. Ce nouveau serveur MCP est conçu pour faire le lien entre RHEL et les grands modèles de langage (LLM), ce qui permet une nouvelle ère de résolution de problèmes plus intelligente.

Qu'est-ce que le serveur MCP pour RHEL ?

Le MCP est une norme ouverte qui permet aux modèles d'IA d'interagir avec des données et des systèmes externes. Il a été lancé par Anthropic et a été transféré en décembre 2025 à l'Agentic AI Foundation de la Linux Foundation. Le nouveau serveur MCP de RHEL est maintenant disponible en version préliminaire pour les développeurs et utilise ce protocole pour fournir un accès direct et contextuel à RHEL à partir d'applications d'IA qui prennent en charge le protocole MCP, comme Claude Desktop ou goose.

Nous avons déjà lancé des serveurs MCP pour Red Hat Lightspeed et Red Hat Satellite qui permettent de concevoir de nombreux cas d'utilisation intéressants. Ce nouveau serveur MCP prend en charge ces cas d'utilisation et est conçu spécialement pour la résolution de problèmes approfondis sur les systèmes RHEL.

Résoudre les problèmes de manière plus intelligente

La connexion de votre LLM à RHEL avec le nouveau serveur MCP permet différents cas d'utilisation, tels que :

- Analyse intelligente des journaux : Le tri des données de journaux est une tâche fastidieuse. Le serveur MCP permet aux LLM d'ingérer et d'analyser les journaux système RHEL. Cette fonctionnalité permet l'analyse des causes profondes basée sur l'IA et la détection d'anomalies. Elle vous aide à transformer les données brutes de journaux en informations exploitables.

- Analyse des performances : Le serveur MCP peut accéder à des informations sur le nombre de processeurs, la charge moyenne, la mémoire, ainsi que l'utilisation du processeur et de la mémoire des processus en cours d'exécution. Cela permet à un système LLM d’analyser l’état actuel du système, d’identifier les goulets d’étranglement potentiels et de formuler d’autres recommandations liées aux performances.

Pour vous aider à découvrir ces nouvelles fonctionnalités de manière plus sûre, cette version préliminaire pour les développeurs se concentre sur l'activation de MCP en lecture seule. Le serveur MCP permet à un LLM d’inspecter et de recommander, et utilise des clés SSH standard pour l’authentification. Il peut également être configuré avec une liste d’autorisation pour l’accès aux fichiers journaux et aux niveaux d’accès aux journaux. Le serveur MCP n'autorise pas l'accès direct au shell de votre système RHEL, car les commandes qu'il exécute sont pré-approuvées.

Cas d'utilisation

Dans ces exemples, j'utilise l'agent d'IA goose, ainsi que le serveur MCP pour fonctionner avec l'un de mes systèmes RHEL 10 nommé rhel10.example.com. Il prend en charge un certain nombre de fournisseurs de LLM, notamment des fournisseurs hébergés en ligne, ainsi que localement. J'utilise un modèle hébergé localement.

J'ai installé goose et le serveur MCP sur mon poste de travail Fedora, avec l'authentification par clé SSH configurée avec rhel10.example.com.

Je vais commencer par une invite qui demande au LLM de m'aider à vérifier l'intégrité du système rhel10.example.com :

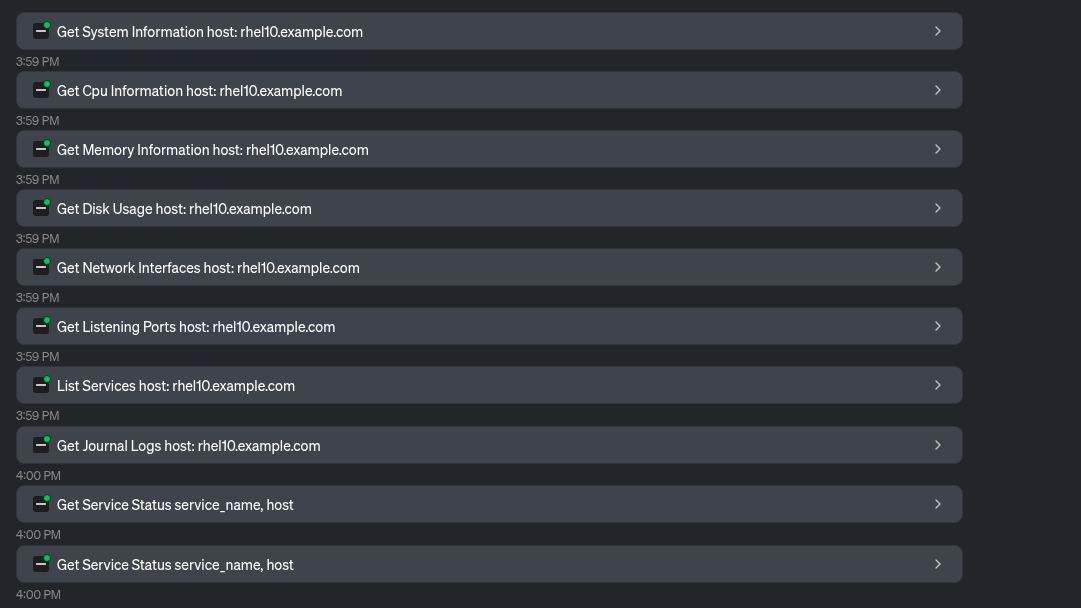

Le LLM utilise un certain nombre d'outils fournis par le serveur MCP pour collecter des informations sur le système :

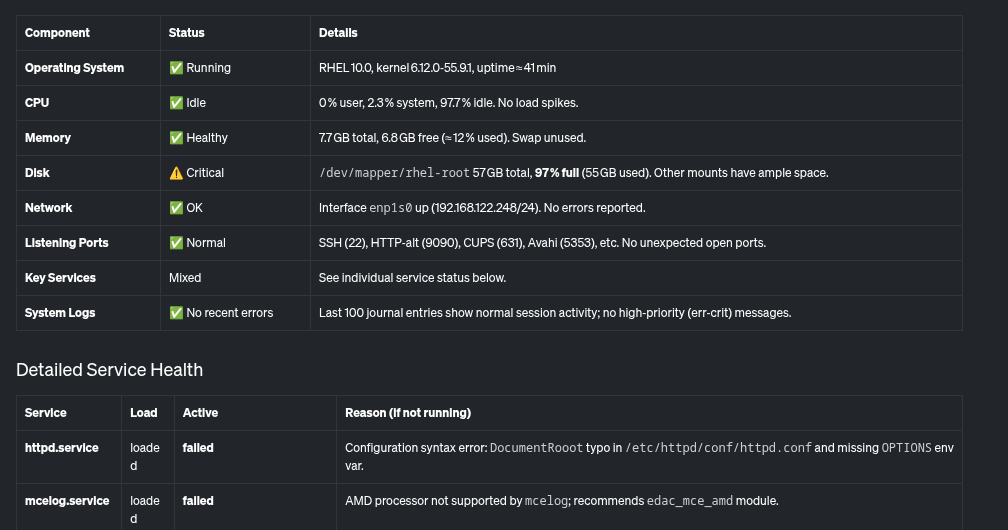

Sur cette base, le LLM fournit un aperçu du système et de son intégrité, notamment dans le tableau suivant :

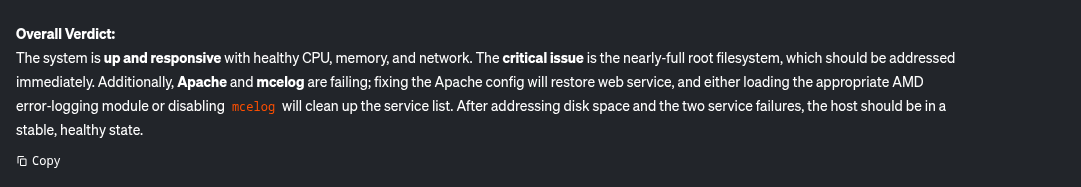

En outre, il fournit ce récapitulatif en indiquant les problèmes critiques à traiter, tels que le système de fichiers racine presque saturé et quelques services qui échouent sur le système.

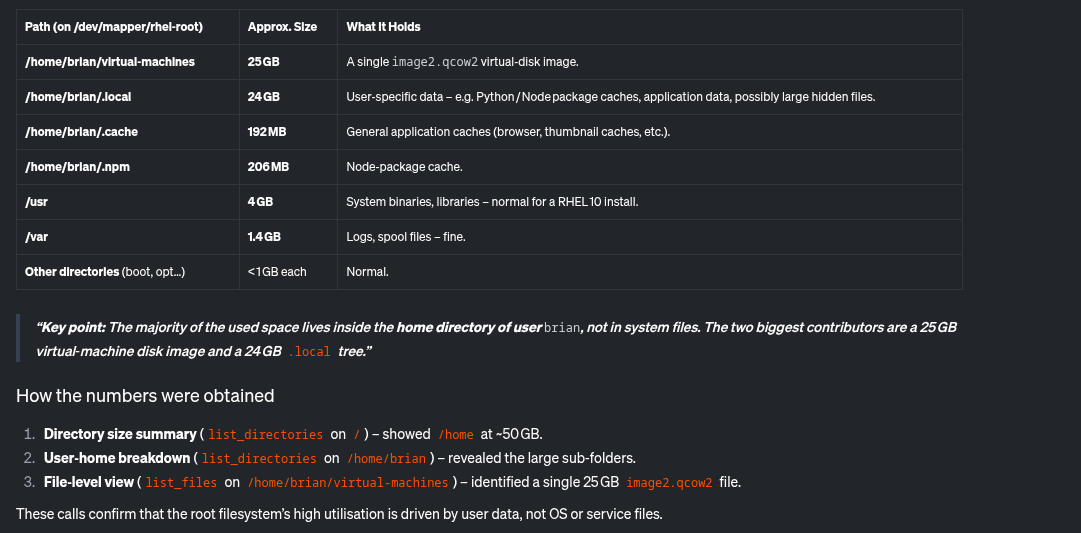

Examinons les problèmes identifiés. Je vais demander au LLM de m'aider à déterminer la cause de l'utilisation élevée du disque :

Le LLM utilise les outils fournis par le serveur MCP pour déterminer ce qui utilise le plus d'espace disque :

Sur cette base, le LLM détermine que le répertoire /home/brian/virtual-machines contient un fichier de 25 Go et que le répertoire /home/brian/.local mobilise 24 Go d'espace de stockage :

Enfin, je vais également demander au LLM de m'aider avec httpd.service, qui a déjà été signalé comme défaillant.

Le LLM utilise l’outil Read File fourni par le serveur MCP :

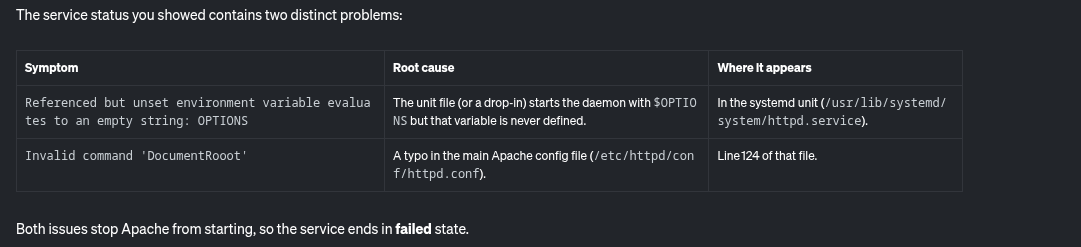

Sur la base de ces éléments, le LLM indique les causes potentielles de la défaillance du service httpd.service :

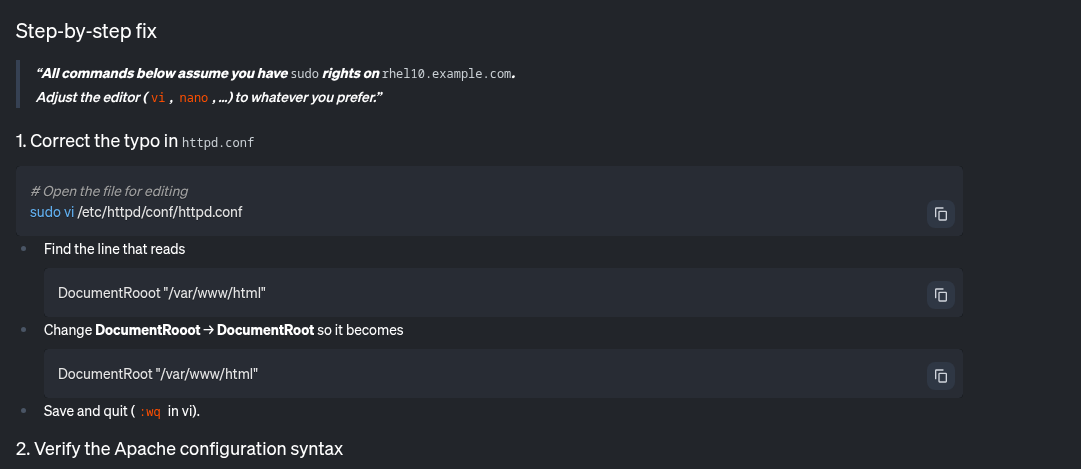

Il fournit également des instructions détaillées pour corriger ce problème :

Le serveur MCP pour RHEL m'a permis d'identifier et de résoudre facilement les problèmes potentiels sur ce système, liés à un système de fichiers presque plein et à un service httpd défaillant.

Et après ?

Bien que nous commencions par une analyse en lecture seule, notre feuille de route prévoit d'intégrer d'autres cas d'utilisation. Pour suivre le processus de développement, gardez un œil sur notre référentiel GitHub en amont. Les contributions en amont sont les bienvenues. Vos commentaires nous intéressent : demandes d'amélioration, rapports de bogues, etc. Vous pouvez rejoindre l'équipe sur GitHub ou par l'intermédiaire du groupe d'intérêt spécial (SIG) Fedora pour l'IA/ML.

Envie de résoudre les problèmes plus intelligemment ?

Le serveur MCP pour RHEL est désormais disponible en version préliminaire pour les développeurs. Connectez votre application cliente LLM et découvrez comment l'IA contextuelle peut changer la façon dont vous gérez RHEL. Pour commencer, reportez-vous à la documentation Red Hat et à la documentation en amont.

Essai de produit

Red Hat Enterprise Linux | Essai de produit

À propos des auteurs

Brian Smith is a product manager at Red Hat focused on RHEL automation and management. He has been at Red Hat since 2018, previously working with public sector customers as a technical account manager (TAM).

Máirín Duffy is a Red Hat Distinguished Engineer and leads the Red Hat Enterprise Linux Lightspeed Incubation team at Red Hat as a passionate advocate for human-centered AI and open source. A recipient of the O’Reilly Open Source Award, Máirín first joined Red Hat as an intern in 2004 and has spent two decades in open source communities focusing on user experience in order to expand the reach of open source. A sought-after speaker and author, Mo holds 19 patents and authored 6 open source coloring books, including The SELinux Coloring Book.

Plus de résultats similaires

AI insights with actionable automation accelerate the journey to autonomous networks

Fast and simple AI deployment on Intel Xeon with Red Hat OpenShift

Technically Speaking | Build a production-ready AI toolbox

Technically Speaking | Platform engineering for AI agents

Parcourir par canal

Automatisation

Les dernières nouveautés en matière d'automatisation informatique pour les technologies, les équipes et les environnements

Intelligence artificielle

Actualité sur les plateformes qui permettent aux clients d'exécuter des charges de travail d'IA sur tout type d'environnement

Cloud hybride ouvert

Découvrez comment créer un avenir flexible grâce au cloud hybride

Sécurité

Les dernières actualités sur la façon dont nous réduisons les risques dans tous les environnements et technologies

Edge computing

Actualité sur les plateformes qui simplifient les opérations en périphérie

Infrastructure

Les dernières nouveautés sur la plateforme Linux d'entreprise leader au monde

Applications

À l’intérieur de nos solutions aux défis d’application les plus difficiles

Virtualisation

L'avenir de la virtualisation d'entreprise pour vos charges de travail sur site ou sur le cloud