Il tuo compito è portare l'IA nella tua organizzazione, ma il passaggio da un'applicazione proof of concept a un'applicazione pronta per la messa in produzione è spesso un labirinto di strumenti frammentati e integrazioni complesse, soprattutto per gli scenari di utilizzo Agentic AI. La vera sfida non è solo la tecnologia, ma anche la creazione di una strategia di IA scalabile, affidabile e gestibile.

La standardizzazione è un fattore fondamentale per affrontare questa sfida, soprattutto perché riduce la complessità e aumenta l'efficienza. Combinando Model Context Protocol (MCP) e Llama Stack su una piattaforma come Red Hat OpenShift AI, puoi creare un ambiente unificato e portabile per le tue applicazioni di IA.

OpenShift AI può anche supportare l'integrazione di qualsiasi altro framework e componente dell’Agentic AI, inclusi strumenti come LangChain, LangGraph e CrewAI, per citarne alcuni. L'approccio di Red Hat può semplificare lo sviluppo, snellire le operazioni e fornire alla tua azienda gli strumenti necessari per consentire a più team, come sviluppatori di IA e data scientist, di trasformare la tua visione dell'IA in realtà all'interno di un ambiente affidabile e coerente.

Comprendere gli elementi costitutivi di un agente intelligente

Per realizzare applicazioni resilienti basate sull'IA, è necessaria una base che consenta agli agenti intelligenti di accedere e utilizzare gli strumenti e i dati specifici dell'azienda. Ciò richiede due componenti chiave: un modo standardizzato per esporre i servizi e un framework unificato per interagire con essi.

Questa è l'essenza dell'Agentic AI, in cui un sistema autonomo può determinare la migliore linea d'azione e gli strumenti necessari per raggiungere un obiettivo. La combinazione di MCP e Llama Stack fornisce il framework per il funzionamento efficace di questi agenti.

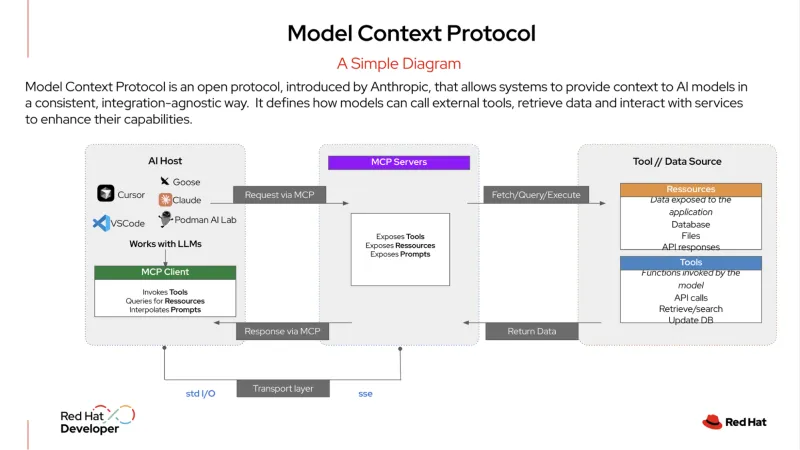

MCP è un protocollo open che standardizza il modo in cui i sistemi di IA si integrano con strumenti e sorgenti di dati esterni. È stato descritto come una "porta USB-C per applicazioni IA". Proprio come un connettore USB-C consente di collegare qualsiasi dispositivo compatibile (un monitor, un disco rigido o una tastiera), un server MCP espone i servizi dell'organizzazione in un formato standardizzato.

Un agente IA può quindi collegarsi a questo server per rilevare e utilizzare gli strumenti disponibili, che si tratti di un database, un sistema di gestione delle relazioni con i clienti (CRM) o un'API interna. Questo protocollo consente agli agenti IA di connettersi ai servizi in modo strutturato, consentendo loro di ottenere facilmente le informazioni necessarie per svolgere le attività.

Llama Stack è un framework open source che offre un approccio unificato e basato su API per la creazione e il deployment di applicazioni di IA generativa (gen AI). Offre un modo coerente e portabile per eliminare le complessità legate allo sviluppo e al deployment dell'IA e include una suite di strumenti aziendali come le API per l'inferenza, la retrieval-augmented generation (RAG) e gli agenti IA. Fornisce inoltre componenti integrati per la sicurezza, la valutazione e l'osservabilità, aiutando le organizzazioni a creare applicazioni di IA pronte per la produzione, affidabili e scalabili.

Un esempio di Agentic AI in azione

Nell'IT enterprise, l'Agentic AI è in grado di gestire flussi di lavoro complessi, con diverse attività, che richiedono processi decisionali dinamici. Ad esempio, invece di rispondere semplicemente a una richiesta con una risposta, un agente più sofisticato può fungere da Service Desk Manager autonomo, risolvendo i problemi con il minimo intervento umano.

Di seguito è riportato un esempio di ciò che questo tipo di agente potrebbe fare quando un utente invia un ticket per una "interruzione del servizio":

- Llama Stack riceve il ticket iniziale. Il sistema riceve il report dell'utente relativo a un'interruzione del servizio e lo classifica come incidente ad alta priorità.

- L'agente utilizza MCP e formula un piano. L'agente utilizza l'MCP per identificare e individuare gli strumenti pertinenti a cui ha accesso, come un servizio di monitoraggio, uno strumento di analisi dei log e un sistema di automazione dei runbook. Nel contesto dell'MCP, l'agente formula un piano in più fasi per indagare e risolvere il problema.

- L'agente esegue il piano utilizzando MCP per comunicare con gli strumenti rilevati.

- Innanzitutto utilizza uno strumento di monitoraggio per verificare lo stato dei servizi e delle dipendenze rilevanti.

- Chiama quindi uno strumento di analisi dei registri al fine di esaminare i registri recenti per un'applicazione correlata o un container Red Hat OpenShift, alla ricerca di errori.

- Nel momento in cui viene identificato un potenziale problema (ad esempio, un pod che si arresta in modo anomalo), utilizza uno strumento diagnostico per individuare il problema alla base, ad esempio una policy di rete non configurata correttamente o un disco pieno.

- L'agente esegue un'azione correttiva. In base alla diagnosi, utilizza MCP per chiamare uno script di correzione preapprovato per riavviare il pod e liberare spazio sul disco. Quindi ricontrolla lo stato del servizio per confermare che il problema sia stato risolto.

- L'agente comunica il risultato. Utilizza uno strumento interno per aggiornare lo stato del ticket su "risolto", incluso un riepilogo delle azioni intraprese. Quindi invia un messaggio all'utente, spiegando il problema e confermando che il servizio è di nuovo online, il tutto senza alcun intervento umano.

Utilizzando l'MCP per orchestrare queste attività, l'agente è in grado di operare come un service desk autonomo e indipendente, riducendo il carico manuale per i team IT e lasciando loro il tempo di concentrarsi su iniziative più strategiche.

Un approccio semplificato per lo sviluppo e la produzione

La combinazione di Llama Stack e MCP migliora notevolmente l'esperienza degli sviluppatori. Invece di creare uno stack specifico e monolitico, gli sviluppatori possono utilizzare un livello di astrazione standardizzato tramite un'unica API. Ciò consente di creare e testare le proprie applicazioni IA su un computer locale utilizzando un unico SDK.

Poiché le API sono coerenti e i servizi vengono rilevati tramite un protocollo standardizzato, gli sviluppatori possono essere certi che la loro applicazione funzionerà esattamente allo stesso modo quando viene distribuita su una piattaforma di livello enterprise.

Questa portabilità è fondamentale in un ambiente di IA in rapida evoluzione. Uno sviluppatore può creare la propria applicazione utilizzando un modello e, se emerge un nuovo modello migliore o più conveniente, può passare a quello nuovo senza dover riscrivere il codice. Questo riduce i tempi e gli sforzi di sviluppo, accelera l'innovazione e fornisce un percorso chiaro per il passaggio dallo sviluppo alla produzione.

Coerenza operativa per i carichi di lavoro di IA

Per i team operativi, la gestione di una gamma diversificata di modelli e servizi di IA può essere una fonte di grande complessità. Tuttavia, eseguendo uno stack di IA standardizzato su misura per la tua organizzazione su una piattaforma come OpenShift AI, ottieni un ambiente centralizzato e coerente.

OpenShift AI offre una piattaforma completa e affidabile per il deployment e l'erogazione di LLM e per l'esecuzione dei database necessari per le applicazioni RAG. Consente inoltre ai team di sfruttare le architetture a microservizi esistenti e di connettersi ai sistemi interni in modo semplice.

I team operativi possono anche utilizzare i processi GitOps standard per distribuire e gestire queste applicazioni di IA. Ciò significa che gli stessi flussi di lavoro utilizzati per le applicazioni cloud native tradizionali possono essere applicati ai carichi di lavoro di IA, semplificando la gestione e la manutenzione su larga scala. Semplifica il passaggio dallo sviluppo alla produzione e garantisce coerenza operativa negli ambienti di hybrid cloud.

Combinando la potenza delle tecnologie open source come Llama Stack e MCP e consentendo l'integrazione di altri framework di IA agentici come LangChain, Haystack, LlamaIndex e PydanticAI, Red Hat AI offre una base affidabile per la creazione, il deployment e la gestione delle applicazioni di IA nel cloud ibrido.

Scopri di più

Inizia subito Scopri di più sulle soluzioni IA di Red Hat attraverso le versioni di prova dei prodotti, i servizi di consulenza, formazione e certificazioni e molto altro ancora.

Risorsa

L'adattabilità enterprise: predisporsi all'IA per essere pronti a un'innovazione radicale

Sugli autori

Younes Ben Brahim is a Principal Product Marketing Manager at Red Hat, focusing on the strategic positioning and market adoption of Red Hat's AI platform offerings. Younes has spent over 15 years in the IT industry leading product marketing initiatives, managing product lifecycles for HPC & AI, and delivering consulting services.

Prior to Red Hat, he has worked with companies like NetApp, Dimension Data, and Cisco Systems, providing technical solutions and product strategy for enterprise infrastructure and software projects.

Carlos Condado is a Senior Product Marketing Manager for Red Hat AI. He helps organizations navigate the path from AI experimentation to enterprise-scale deployment by guiding the adoption of MLOps practices and integration of AI models into existing hybrid cloud infrastructures. As part of the Red Hat AI team, he works across engineering, product, and go-to-market functions to help shape strategy, messaging, and customer enablement around Red Hat’s open, flexible, and consistent AI portfolio.

With a diverse background spanning data analytics, integration, cybersecurity, and AI, Carlos brings a cross-functional perspective to emerging technologies. He is passionate about technological innovations and helping enterprises unlock the value of their data and gain a competitive advantage through scalable, production-ready AI solutions.

Will McGrath is a Senior Principal Product Marketing Manager at Red Hat. He is responsible for marketing strategy, developing content, and driving marketing initiatives for Red Hat OpenShift AI. He has more than 30 years of experience in the IT industry. Before Red Hat, Will worked for 12 years as strategic alliances manager for media and entertainment technology partners.

Roberto is a Principal AI Architect working in the AI Business Unit specializing in Container Orchestration Platforms (OpenShift & Kubernetes), AI/ML, DevSecOps, and CI/CD. With over 10 years of experience in system administration, cloud infrastructure, and AI/ML, he holds two MSc degrees in Telco Engineering and AI/ML.

Cedric Clyburn (@cedricclyburn), Senior Developer Advocate at Red Hat, is an enthusiastic software technologist with a background in Kubernetes, DevOps, and container tools. He has experience speaking and organizing conferences including DevNexus, WeAreDevelopers, The Linux Foundation, KCD NYC, and more. Cedric loves all things open-source, and works to make developer's lives easier! Based out of New York.

Altri risultati simili a questo

AI insights with actionable automation accelerate the journey to autonomous networks

Fast and simple AI deployment on Intel Xeon with Red Hat OpenShift

Technically Speaking | Build a production-ready AI toolbox

Technically Speaking | Platform engineering for AI agents

Ricerca per canale

Automazione

Novità sull'automazione IT di tecnologie, team e ambienti

Intelligenza artificiale

Aggiornamenti sulle piattaforme che consentono alle aziende di eseguire carichi di lavoro IA ovunque

Hybrid cloud open source

Scopri come affrontare il futuro in modo più agile grazie al cloud ibrido

Sicurezza

Le ultime novità sulle nostre soluzioni per ridurre i rischi nelle tecnologie e negli ambienti

Edge computing

Aggiornamenti sulle piattaforme che semplificano l'operatività edge

Infrastruttura

Le ultime novità sulla piattaforma Linux aziendale leader a livello mondiale

Applicazioni

Approfondimenti sulle nostre soluzioni alle sfide applicative più difficili

Virtualizzazione

Il futuro della virtualizzazione negli ambienti aziendali per i carichi di lavoro on premise o nel cloud