Há muito tempo, os administradores e desenvolvedores de sistemas do Red Hat Enterprise Linux (RHEL) contam com um conjunto específico de ferramentas para diagnosticar problemas, aliado a anos de experiência e conhecimento acumulados. No entanto, à medida que os ambientes se tornam mais complexos, a carga cognitiva necessária para decifrar logs e solucionar problemas de forma eficaz tem aumentado.

Hoje, temos o prazer de anunciar a apresentação prévia para desenvolvedores de um novo servidor do Model Context Protocol (MCP) para o RHEL. Este novo servidor MCP foi projetado para preencher a lacuna entre o RHEL e os Large Language Models (LLMs), abrindo caminho para uma nova era de solução de problemas mais inteligente.

O que é o servidor MCP para RHEL?

MCP é um padrão aberto que permite que modelos de AI interajam com dados e sistemas externos, originalmente lançado pela Anthropic e doado em dezembro de 2025 para a Agentic AI Foundation da Linux Foundation. O novo servidor MCP do RHEL está agora na apresentação prévia para desenvolvedores e usa esse protocolo para fornecer acesso direto e baseado no contexto ao RHEL a partir de aplicações de AI compatíveis com o protocolo MCP, como Claude Desktop ou goose.

Já lançamos servidores MCP para o Red Hat Lightspeed e o Red Hat Satellite, possibilitando diversos casos de uso interessantes. Este novo servidor MCP amplia esses cenários de uso, projetado sob medida para o troubleshooting avançado em sistemas RHEL.

Habilitando uma solução de problemas mais inteligente

Conectar seu LLM ao RHEL com o novo servidor MCP possibilita casos de uso como:

- Análise inteligente de logs: examinar dados de logs é uma tarefa exaustiva. O servidor MCP permite que os LLMs assimilem e analisem os logs do sistema RHEL. Esse recurso permite a análise da causa raiz orientada por IA e a detecção de anomalias, ajudando você a transformar dados brutos de log em inteligência acionável.

- Análise de desempenho: o servidor MCP pode acessar informações sobre o número de CPUs, a média de carga, informações da memória e informações sobre o uso de CPU e memória dos processos em execução. Isso permite que um sistema LLM analise o estado atual do sistema, identifique possíveis gargalos de desempenho e faça outras recomendações relacionadas ao desempenho.

Para ajudar você a explorar esses novos recursos de maneira mais segura, esta apresentação prévia para desenvolvedores se concentra na habilitação do MCP somente leitura. O servidor MCP permite que um LLM inspecione e recomende, e utiliza chaves SSH padrão para autenticação. Ele também pode ser configurado com uma lista de permissões para acesso ao arquivo de log e acesso ao nível de log. O servidor MCP não permite acesso open shell ao seu sistema RHEL, pois os comandos executados por ele são pré-verificados.

Exemplos de casos de uso

Nesses exemplos, estou usando o agente de agentic AI goose com o servidor MCP para trabalhar com um dos meus sistemas RHEL 10 chamado rhel10.example.com. O Goose é compatível com vários provedores de LLM, incluindo provedores online hospedados e provedores hospedados localmente. Estou usando um modelo hospedado localmente.

Instalei o Goose e o servidor MCP na minha estação de trabalho Fedora, com a autenticação de chave SSH configurada com rhel10.example.com.

Começarei com um prompt solicitando ao LLM que me ajude a verificar a integridade do sistema rhel10.example.com:

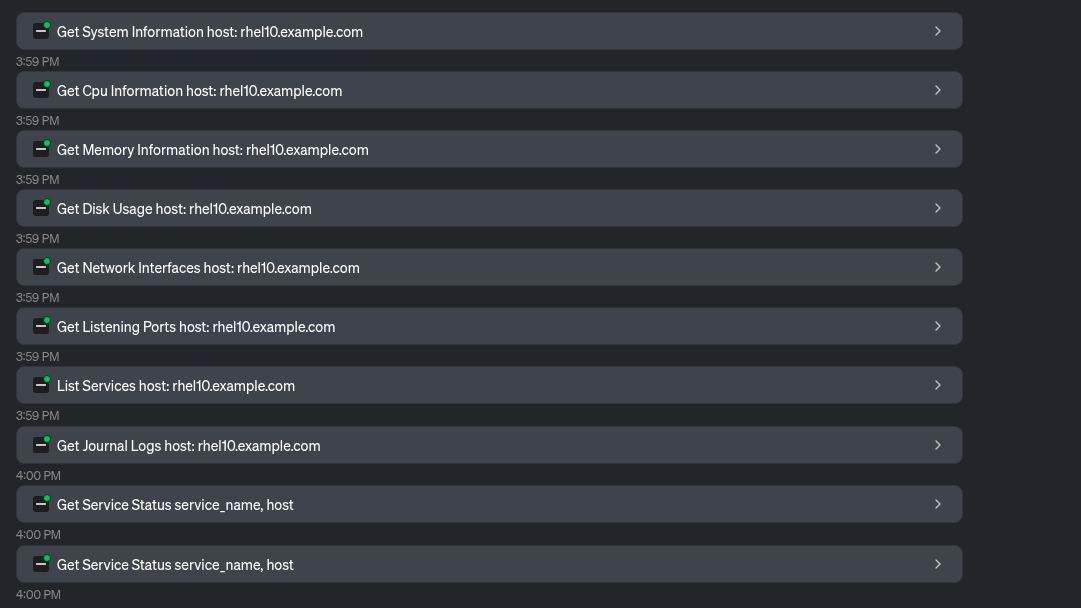

O LLM utiliza diversas ferramentas fornecidas pelo servidor MCP para coletar informações do sistema:

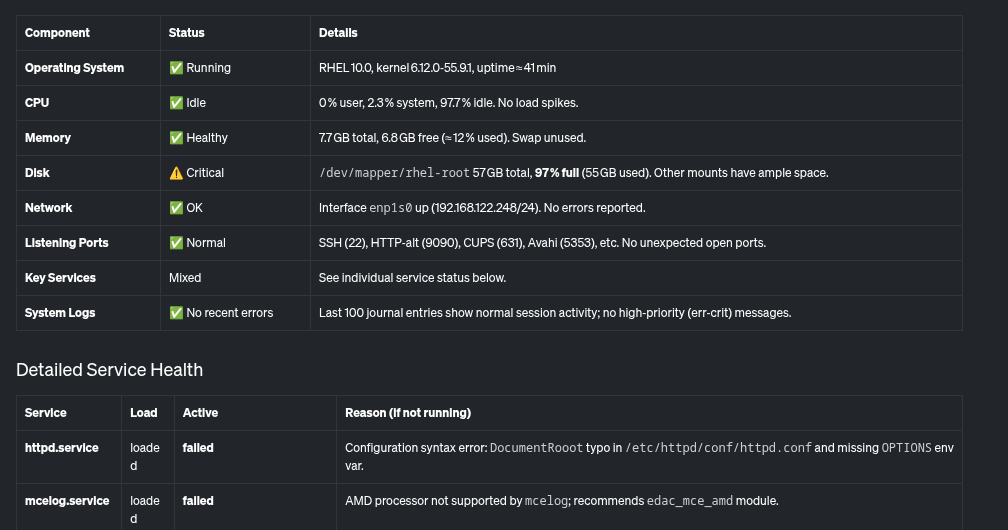

Com base nisso, o LLM oferece uma visão geral do sistema e sua integridade, incluindo esta tabela:

Além disso, ele fornece este resumo, observando os problemas críticos que precisam ser abordados, como o sistema de arquivos raiz quase cheio e alguns serviços com falha no sistema.

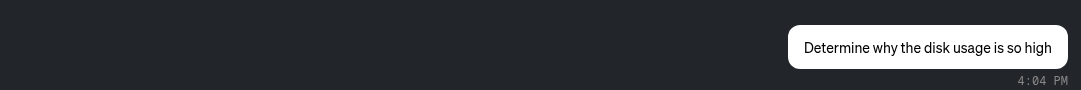

Vamos examinar os problemas identificados. Solicitarei ao LLM que me ajude a determinar por que o uso do disco está tão alto:

O LLM usa ferramentas fornecidas pelo servidor MCP para determinar o que está usando mais espaço em disco:

Com base nisso, o LLM determina que o diretório /home/brian/virtual-machines tem um arquivo de 25 GB e que o diretório /home/brian/.local está ocupando 24 GB de espaço:

Por fim, também solicitarei ao LLM que ajude com o httpd.service, que foi relatado anteriormente como apresentando falhas.

O LLM usa a ferramenta Read File fornecida pelo servidor MCP:

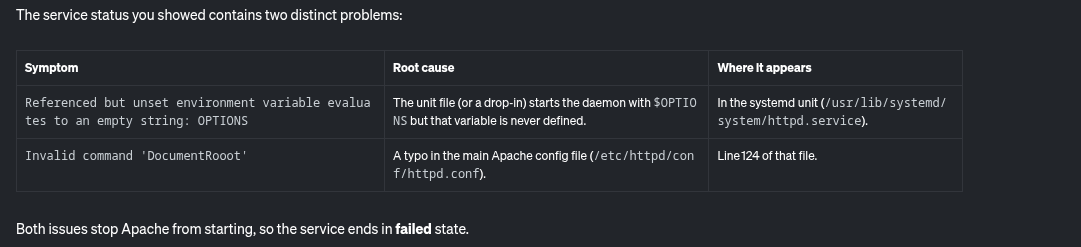

Com base nisso, o LLM relata as possíveis causas da falha do httpd.service:

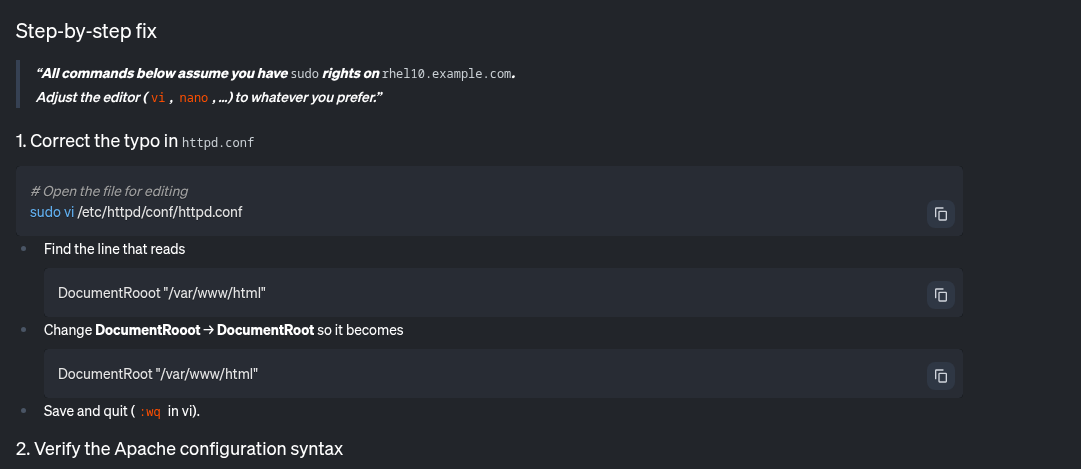

Além disso, ele também fornece algumas instruções passo a passo para corrigir isso:

O servidor MCP para RHEL me permitiu identificar e solucionar facilmente possíveis problemas nesse sistema relacionados a um sistema de arquivos quase cheio e a um serviço httpd com falha.

Quais são os próximos passos?

Estamos começando com a análise somente leitura, mas nosso roadmap pretende expandir para outros casos de uso. Para acompanhar o processo de desenvolvimento, fique de olho em nosso repositório do GitHub upstream. Contribuições upstream são bem-vindas! Estamos muito interessados no seu feedback: solicitações de aprimoramento, relatórios de bugs e assim por diante. Você pode entrar em contato com a equipe pelo GitHub ou pelo Fedora AI/ML Special Interest Group (SIG).

Tudo pronto para uma solução de problemas mais inteligente?

O servidor MCP para RHEL já está disponível na apresentação prévia para desenvolvedores. Conecte sua aplicação cliente do LLM e veja como a agentic AI contextual pode mudar a maneira como você gerencia o RHEL. Para começar, consulte a documentação da Red Hat e a documentação do upstream.

Teste de produto

Red Hat Enterprise Linux | Teste da solução

Sobre os autores

Brian Smith is a product manager at Red Hat focused on RHEL automation and management. He has been at Red Hat since 2018, previously working with public sector customers as a technical account manager (TAM).

Máirín Duffy is a Red Hat Distinguished Engineer and leads the Red Hat Enterprise Linux Lightspeed Incubation team at Red Hat as a passionate advocate for human-centered AI and open source. A recipient of the O’Reilly Open Source Award, Máirín first joined Red Hat as an intern in 2004 and has spent two decades in open source communities focusing on user experience in order to expand the reach of open source. A sought-after speaker and author, Mo holds 19 patents and authored 6 open source coloring books, including The SELinux Coloring Book.

Mais como este

AI insights with actionable automation accelerate the journey to autonomous networks

Fast and simple AI deployment on Intel Xeon with Red Hat OpenShift

Technically Speaking | Build a production-ready AI toolbox

Technically Speaking | Platform engineering for AI agents

Navegue por canal

Automação

Últimas novidades em automação de TI para empresas de tecnologia, equipes e ambientes

Inteligência artificial

Descubra as atualizações nas plataformas que proporcionam aos clientes executar suas cargas de trabalho de IA em qualquer ambiente

Nuvem híbrida aberta

Veja como construímos um futuro mais flexível com a nuvem híbrida

Segurança

Veja as últimas novidades sobre como reduzimos riscos em ambientes e tecnologias

Edge computing

Saiba quais são as atualizações nas plataformas que simplificam as operações na borda

Infraestrutura

Saiba o que há de mais recente na plataforma Linux empresarial líder mundial

Aplicações

Conheça nossas soluções desenvolvidas para ajudar você a superar os desafios mais complexos de aplicações

Virtualização

O futuro da virtualização empresarial para suas cargas de trabalho on-premise ou na nuvem